2024年11月01日,第20届User Friendly国际用户体验大会在深圳圆满落幕。在1日下午的议程中,大会开设4个行业平行峰会,其中在智能交互峰会上,我们有幸邀请到了来自浙江大学国际设计研究院副院长 张克俊教授为我们带来了一场关于“跨模态体验计算与设计”的精彩演讲。

主讲嘉宾简介

趋势引导演讲|精彩瞬间

我今天分享的主题是《跨模态体验计算与设计》。

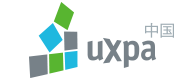

互联网、移动计算、超级计算、穿戴设备、物联网、云计算、人工智能等技术的发展,推动信息环境巨变。数字空间、物理世界与人类社会迅速融合———三元世界。

马克思、恩格斯提出生产力和生产关系时,那时候的劳动资料可能就是一把锄头,所以它不可能被当成劳动者,而今天的大模型在某种意义上是“劳动者”,是一个双引号的“人”,所以我们对相应的生产关系也要进行某种意义上的重新认识。

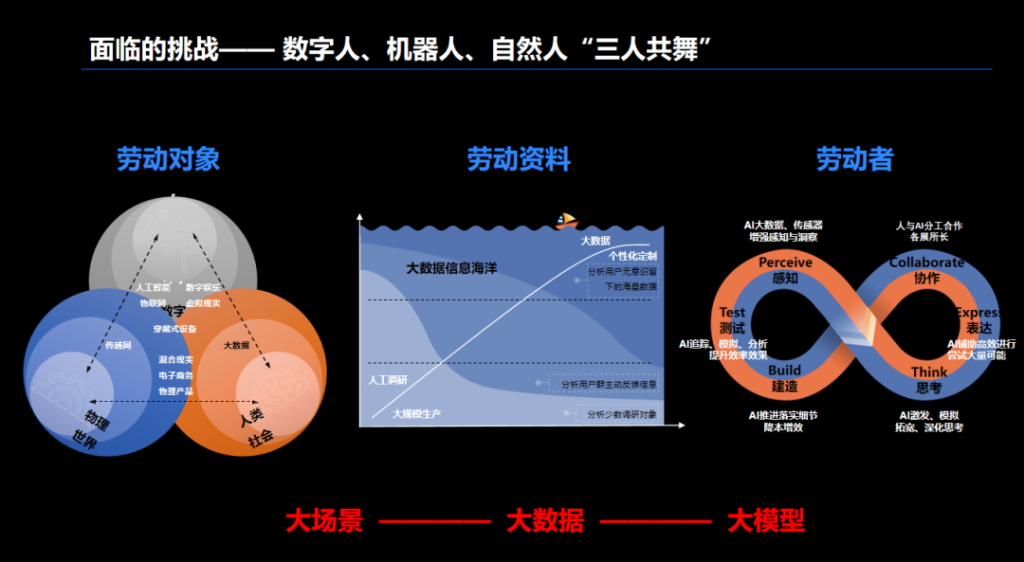

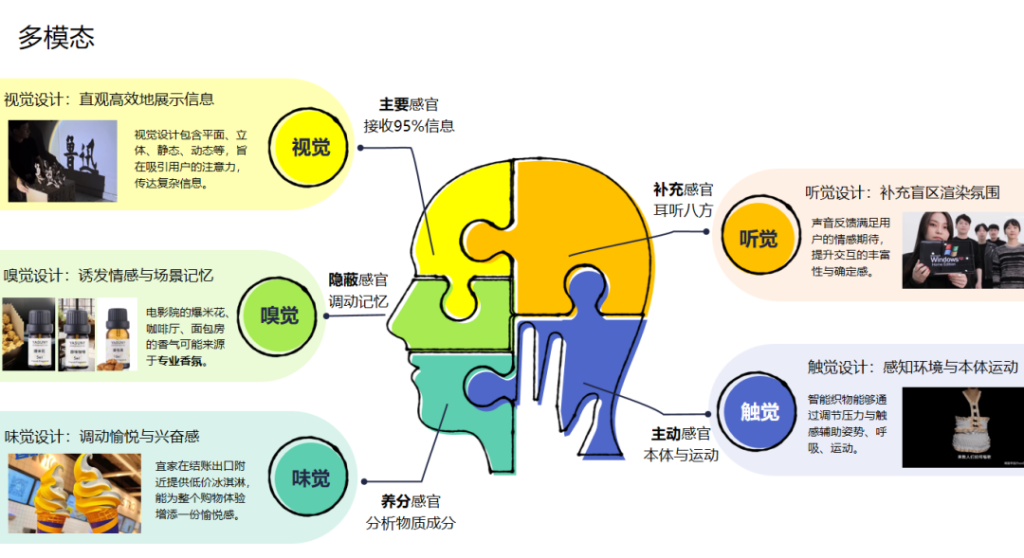

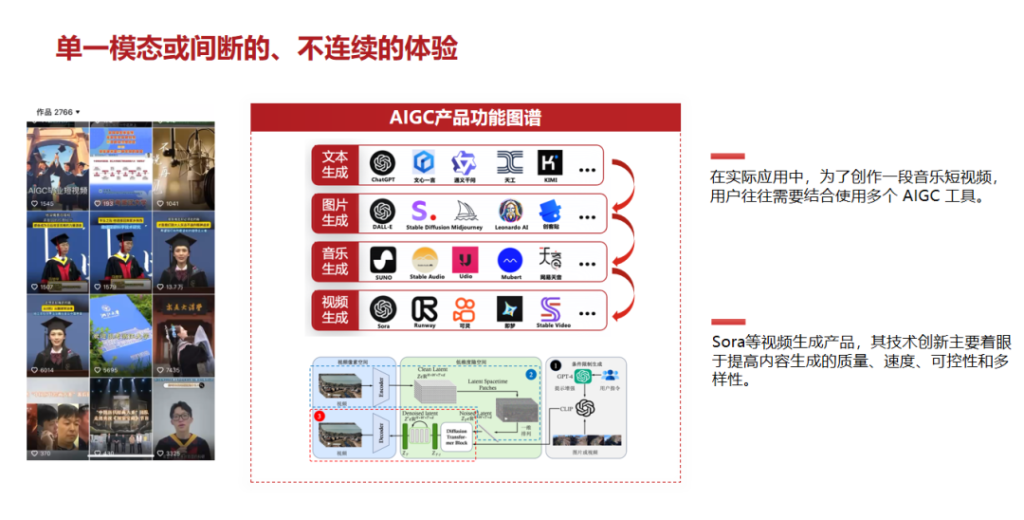

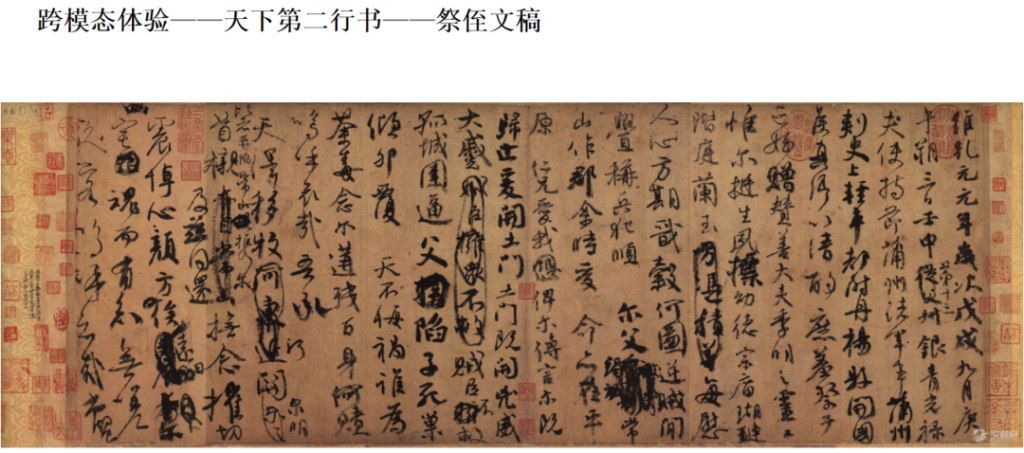

多模态侧重于融合和利用不同模态的数据,例如文本处理,图像、视频处理等。而跨模态则是不同数据之间的迁移、转换,如用一种模态映射另外一种模态,形成双重的反馈。多模态和跨模态的融合是AIGC发展非常重要的趋势和方向。

数字内容创作——跨模态体验计算与设计

以传统视频和现在AIGC做视频的区别为例,我们可以看到:传统视频制作链路长,涉及众多角色,且高度依赖人工,耗时费力且难以实现规模化生产 。AIGC 技术,不仅利用人工智能算法实现了文本、 图像、音频、视频等内容的自动生成,而且打造的对话式人机交互形式,极大提升了创作效率与用户体验。

最后,以情感作为主线与大家分享我们实验室做的一些实践与探索。

第一个是跑步生成音乐的产品Stepbeats。它让你跑步时候所听的音乐节奏,跟随你的跑步速度而改变,某种意义上实现了人与音乐的双向沟通。

如果跑步的节奏可以控制音乐的节奏,那么视觉、温度、湿度等环境的变化是不是也可以控制音乐的节奏?我们把视觉信息和听觉信息进行融合,利用情感进行关联匹配,把两种不相关的东西映射到情感这一第三空间中,构建了音感模型,实现了视觉和听觉的关系建模。

设计与计算的融合带来的改变是:既结合了场景,也能用相应的技术让它落地。